De la théorie aux données

Qu’est-ce que l’opérationnalisation de concepts?

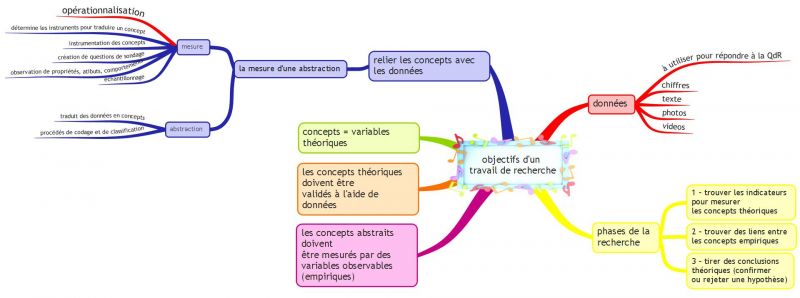

«Etablir un lien entre concepts et données constitue une étape des plus importantes et des plus difficiles dans un travail de recherche. (...) Elle consiste à opérer une traduction fondée sur deux démarches: la mesure et l’abstraction. La mesure consiste à déterminer les indicateurs ou instruments de mesure nécessaires à la traduction d’un concept. La mesure représente ce que certains auteurs désignent sous le nom d’opérationnalisation ou encore d’instrumentation des concepts. L’abstraction permet, au contraire, de traduire des données en concepts grâce à des procédés de codage et de classification». Argot & Milano (2007). Comment lier concepts et données?

- Thietart (Ed.), Méthodes de recherche en Management, pp. 173-191.

La notion d'opérationalisaton

L’opérationnalisation est un élément très important dans le processus de la recherche empirique. Une proposition scientifique comprend des concepts (variables théoriques), dont voici des exemples types: intérêt pour l’apprentissage, performance, efficacité, ou interactivité.

Un article scientifique, rapportant une recherche de type empirique, cherche à établir des liens entre des concepts (variables théoriques) et à valider ces liens à l’aide de données. Ces concepts abstraits comme intérêt pour l'apprentissage ne peuvent pas être observés directement et il faut chercher des variables observables sur le terrain.

Il s'agit donc de trouver des indicateurs et éventuellement calculer des indices qui peuvent mesurer vos concepts théoriques. Dans un deuxième temps, il vous faut trouver des corrélations entre ces variables issues du terrain. Enfin, à partir de ces analyses, vous pouvez tirer des conclusions théoriques, par exemple confirmer ou infirmer une hypothèse.

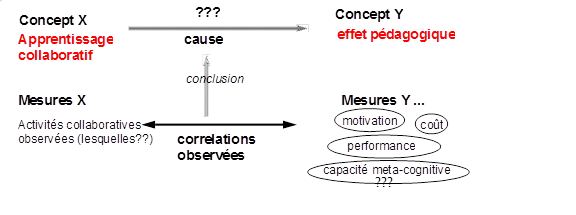

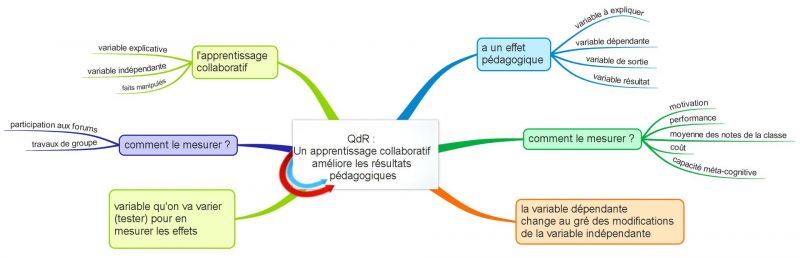

Exemple: Un apprentissage collaboratif améliore les résultats pédagogiques(Figure 16)

Nous avons deux variables pour cet exemple:

- Variable explicative (indépendante): apprentissage collaboratif

- Variable à expliquer (dépendante): effet pédagogique

Ce cas de figure pose un vrai problème! Comment pouvons-nous mesurer l’ «effet pédagogique» ou l’ «apprentissage collaboratif»? Il n’est pas simple d’obtenir de bonnes mesures.

Le lien/écart entre un concept théorique et des mesures

Lorsque vous opérationnalisez un concept, deux obstacles se présentent. Vous devez minimiser deux oppositions (inévitables) entre des variables théoriques et des variables observables.

(1) De l’abstrait au concret. Un concept théorique ne peut pas être mesuré directement, mais uniquement au moyen d’une série de données issues de l’observation.

Exemples:

- Vous pourriez mesurer la «participation des étudiants» par l’intermédiaire du «nombre de messages postés sur des forums»

- Vous pourriez mesurer le «succès pédagogique» par l’intermédiaire des «notes moyennes obtenues dans une classe lors d’examens»

(2) Du tout aux parties. Souvent, un concept est relativement complexe, dans la mesure où il comprend plusieurs dimensions.

Voici quelques exemples pour illustrer ce point.

1. Le socio-constructivisme renvoie à une école de pensée pédagogique. Si vous prévoyez de mesurer le «socio-constructivisme» d’un design pédagogique, vous devriez prendre en considération plusieurs dimensions. Le concept de «design socio-constructiviste» peut être décomposé de la façon suivante: (1) apprentissage actif ou constructif, (2) apprentissage orienté sur soi, (3) apprentissage contextuel, (4) apprentissage collaboratif et (5) comportement interpersonnel de l’enseignant (Dolmans et al. 2003). Il pourrait aussi, selon le modèle d’enseignement socio-constructiviste du cycle d’apprentissage des 5 E se décomposer comme suit: Engagement, Exploration, Explication, Elaboration et Evaluation.

2. Dans le domaine de l’analyse des politiques publiques, le «développement économique» est un concept important. Cette variable englobe souvent l’industrialisation, l’urbanisation, les transports, les communications et l’éducation.

3. Dans le domaine des études sur l’interaction personne-machine, l’ « utilisabilité » est un facteur important, qui peut être décomposé en une série de concepts : l’utilité (le rôle est-il rempli), le principe associé de l’ « utilisabilité cognitive » (ce que le logiciel permet de réaliser) et enfin l’ « utilisabilité de base » (pouvez-vous naviguer, trouver les boutons, etc.).

Pour pratiquer:

Essayez de décomposer un concept que vous trouvez intéressant, puis essayez de l’opérationnaliser.

Décomposez le concept de la «compétence d’enseignement».

Choisissez l’un des concepts que nous avons décomposés précédemment et décrivez votre opinion de cette décomposition. Avons-nous oublié quelque chose ? Cette décomposition pourrait-elle s’appliquer à un concept qui vous est familier?

{{#set:bloc pratiquer=true}}

Résumé ― dangers et problèmes relatifs à l’opérationnalisation de concept

Voici un résumé de la partie consacrée à l’opérationnalisation de concept (Tableau 12). Réfléchissez de façon critique à certains points:

- L’écart entre données et théorie

- Exemple: mesurer la communication au sein d’une communauté de pratique (par exemple un groupe formé en ligne) en prenant comme référence le nombre de messages échangés sur des forums.

- Problème: les apprenants peuvent utiliser d’autres canaux de communication!

- Vous avez peut-être oublié une dimension

- Exemple: mesurer l’usage de la technologie par une classe en s’intéressant uniquement à la technologie utilisée par l’enseignant (e.g. logiciel powerpoint; démonstrations avec logiciels de simulation; logiciels de mathématiques).

- Problème: vous ne prenez pas en compte les activités techno-pédagogiques des apprenants.

- Il pourrait y avoir une surcharge de concept

- Exemple: inclure l’«éducation» dans la définition du développement - cela pourrait être envisagé, mais vous perdriez une variable explicative importante du développement. Pensez à l’Inde, par exemple, qui a surinvesti dans l’éducation afin d’influencer le développement.

- Problème: vous ne devez jamais utiliser des variables explicatives et des variables expliquées dans un même concept.

- Mauvaises mesures

- Le type de mesures que vous envisagez de choisir pourrait ne pas être efficace pour mesurer le concept (i.e. validité des variables).

- Tableau 12: Dangers et problèmes liés à l'opérationnalisation de concepts

Mesures et recueil de données

Dès que vous aurez opérationnalisé vos questions de recherche (i.e. peut inclure des hypothèses opérationnelles), vous devrez réfléchir soigneusement aux types de données que vous recueillerez et aux cas (population) auxquels vous vous intéresserez (Figure 17).

Les moyens de mesure, associés aux méthodes de recueil de données, les plus couramment utilisés sont les suivants:

- Création (si nécessaire) de données à l’aide d’artéfacts (par exemple des questions de sondage);

- Observation des propriétés, attributs, comportements, etc.;

- Sélection de cas que vous allez étudier (échantillonnage).

Selon Randolph (2008), les méthodes de recueil de données les plus utilisées en technologie éducative sont:

- Les questionnaires, moyen idéal d’interroger un grand nombre de personnes et de répondre clairement à des questions de recherche précises;

- Les données enregistrées par le système (log), qui permettent d’étudier comment les utilisateurs utilisent le système (e.g. les outils utilisés, sur quelle durée; les personnes avec lesquelles ils interagissent);

- Les tests, pour déterminer comment les connaissances évoluent avec le temps, par exemple après une intervention de formation;

- Les entretiens;

- Les observations directes;

- Les exercices;

- Les sondages auprès d’enseignants;

- Les tests (standardisés);

- Les schémas d’analyse narrative;

- Le nombre d’exercices soumis plus d’une fois;

- Le temps consacré à une tâche (électronique);

- Les focus group(entretiens de groupe pour faire ressortir les opinions communes et controversées d’un groupe);

- Le taux de réussite.

Pour catégoriser les différentes méthodes de recueil de données ― et par conséquent les différents moyens de mesure, il est important de distinguer entre:

- les données provoquées par le chercheur (e.g. les entretiens);

- les données résultant d’observations (e.g. les observations en classe);

- les données déjà existantes (e.g. les statistiques officielles ou les données enregistrées par le système dans un environnement d’apprentissage en ligne).

Qu’est-ce que des «données»? Il s’agit de chiffres, d’éléments textuels, de données enregistrées par le système, de photos, de séquences vidéo, etc. que vous allez utiliser pour répondre à votre question de recherche.

Le Tableau 13 présente les principales formes de recueil de données (processus que l’on appelle également acquisition de données ou mesures).

| Articulation | |||||

|---|---|---|---|---|---|

| non-verbale et verbale |

verbale | ||||

| orale | écrite | ||||

| Situation | informelle | Observation participative | Entretien d’information | Analyse textuelle, analyse de données enregistrées par le système, etc. | |

| formelle et non structurée | Observation systématique | Entretiens ouverts, entretiens semi-structurés, protocoles pensée à haute voix | Questionnaires ouverts, journaux, vignettes, ... | ||

| formelle et structurée | Expérience, simulation | Entretien standardisé (entretien directif) | Questionnaires standardisés; données enregistrées par le système sur des interactions structurées d’utilisateurs | ||

- - Tableau 13: Formes principales de recueil de données

Echantillonnage

L’échantillonnage correspond au processus de sélection des cas, c’est-à-dire de personnes, d’activités, de situations, etc., que vous prévoyez d’étudier. Ces cas doivent être représentatifs de l’ensemble de la «population» que vous souhaitez analyser. Par exemple, dans une enquête par sondage, les 500 personnes qui répondront au questionnaire doivent être représentatives du groupe de personnes qui vous intéresse (e.g. tous les enseignants d’école primaire d’un pays; tous les étudiants d’une université; tous les électeurs d’un Etat).

Règle importante à se rappeler pour effectuer l’échantillonnage: assurez-vous que les variables opératoires aient de la variance, sans quoi vous ne pourrez pas vous prononcer sur la causalité ou la différence. Nous définissons les variables opératoire comme l’ensemble des variables dépendantes (à expliquer) et indépendantes (explicatives).

Nous vous rappelons que «les variables se distinguent les unes des autres en fonction de leur statut, de la place qu’elles occupent dans un modèle explicatif, de la fonction qu’elles jouent dans une hypothèse. Les variables indépendantes sont les faits manipulés (qu’on fait varier) de façon ‘contrôlée’, pour pouvoir mesurer les effets de ces variations. (On dit aussi : variable explicative, variable manipulée, cause, invoquées, provoquées, variable d’entrée). Les variables dépendantes sont les faits dont la modification est fonction (dépend/est entraînée par) de celle des variables indépendantes. (On dit aussi : variable expliquée, variable effet, variable résultat, variable sortie)». Sall, N. H., p. 19.

Dans la recherche quantitative, l’échantillonnage est relativement simple. Sélectionnez un nombre de cas suffisamment élevé au sein d’une population mère donnée (i.e. la population concernée par votre théorie). La meilleure stratégie d’échantillonnage consiste à sélectionner aléatoirement un échantillon à partir d’une population mère, mais la difficulté est d’identifier tous les membres de cette population mère et d’obtenir leur participation.

L’échantillonnage peut être plus complexe lorsqu’il s’agit d’une recherche qualitative. Le Tableau 14 donne un bref aperçu de différentes stratégies d’échantillonnage que vous pourriez utiliser et qui sont répertoriées de manière plus détaillées dans les différents ouvrages de Miles & Huberman.

|

Types de cas sélectionnés |

Utilisation et effet sur votre stratégie d’investigation |

|

Variation maximale |

Type d'échantillonnage dont l’objectif est de rendre compte de la solidité de «patterns» ou thèmes communs importants en la mettant à l’épreuve de cas extrêmement variés. => Vos résultats seront potentiellement meilleurs mais les modèles requis sont plus complexes, car vous devrez traiter plus de variables |

|

Homogènes |

Type d'échantillonnage dont l’objectif est de se concentrer sur des personnes ayant des caractéristiques démographiques et sociales similaires. => Permet de tirer des conclusions plus précises car il sera plus facile d’identifier des variables explicatives et de «tester» des relations |

|

Critiques |

Type d'échantillonnage dont l'objectif permet une généralisation logique et une application maximale de l'information recueillie auprès d'autres cas. Le cas critique permet de «prouver», d’illustrer les résultats principaux. => Permet d’exemplifier une théorie avec un «exemple naturel» |

|

En fonction de votre théorie, c’est-à-dire de vos questions de recherche |

=> Donnent de meilleures garanties pour répondre à vos questions de recherche... |

|

Cas extrêmes et déviants |

Type d'échantillonnage dont l'objectif permet l'apprentissage à partir de manifestations inhabituelles du phénomène étudié. => Aide à chercher les limites de vos résultats et à trouver de nouveaux sujets de recherche |

|

Intenses |

=> Complètent une étude quantitative avec une étude en profondeur |

Tableau 14: Brève liste de stratégies d’échantillonnage dans une recherche qualitative

Il est important que vous compreniez que les stratégies d’échantillonnage dépendent beaucoup de votre question de recherche et qu’il n’y a pas de réponse tout faite.

Pour pratiquer:

On vous demande de mener une étude préliminaire sur la façon dont les enseignants utilisent une plateforme de formation à distance dans votre université. Votre budget étant limité, vous pouvez interroger seulement six professeurs. Veuillez indiquer comment vous comptez les choisir et pourquoi.

{{#set:bloc pratiquer=true}}

Fiabilité de la mesure

La fiabilité correspond au degré de cohérence relatif à une mesure obtenue pour un même objet...

- ... par différents observateurs

- ... par le même observateur à des moments différents

- ... par le même observateur avec des outils (légèrement) différents

Exemple: Mesure de l’eau bouillante

- Un thermomètre indique constamment une température de 92 C:

- il est fiable (mais pas valable / pertinent)

- Un autre thermomètre indique une température entre 99 et 101 C:

- il n’est pas vraiment fiable (mais valable / pertinent)

Certains auteurs, notamment Kirk & Miller, distinguent d'autres types de fiabilité

- fiabilité circonstancielle: le fait que vous obteniez toujours le même résultat ne signifie pas que les réponses soient fiables (e.g. les personnes peuvent mentir);

- fiabilité diachronique: le même type de mesures continuent de marcher sur la durée;

- fiabilité synchronique: nous obtenons des résultats similaires en utilisant des méthodes différentes (e.g. questions de sondages utilisées avec des entretiens qualitatifs).

En résumé, pouvons-nous reproduire une recherche? Les données sur lesquelles se base une recherche sont-elles fiables?

La fiabilité peut aussi être comprise dans un sens plus large. Les mesures empiriques sont soit directement utilisées comme des indicateurs pour des variables théoriques, soit utilisées pour constituer ce que l’on appelle les indices. Par conséquent, un «indicateur» n’est qu’un terme désignant une mesure individuelle ou un indice composé de plusieurs mesures.

Quoi qu’il en soit, les mesures (indicateurs) peuvent être problématiques pour plusieurs raisons, et vous devriez garder à l’esprit les «3 c»:

- 1. Vos données sont-elles complètes?

- Problème: les données manquent pour certains cas.

- Solution: essayez de trouver d’autres indicateurs.

- 2. Vos données sont-elles correctes?

- Problème: la fiabilité des indicateurs est parfois mauvaise.

- Exemple: les évaluations de logiciels ne signifient pas toujours la même chose dans toutes les cultures. Dans certaines sous-cultures, certaines organisations ou certains pays, les gens peuvent être plus ou moins directs.

- Solution: il n’existe pas de solution toute faite pour ce problème

- 3. Vos données sont-elles comparables?

- La signification de certaines données n’est pas toujours comparable. Exemples:

- (a) Le budget consacré à l’éducation ne signifie pas la même chose d’un pays à l’autre car les niveaux de vie sont différents d’un pays à l’autre.

- (b) Le pourcentage d’activités réalisées en classe ne représente pas la sensibilité «socio-constructive» d’un enseignant (car les différences culturelles entre systèmes scolaires sont énormes d’un pays à l’autre et il existe des activités qui ne sont pas socio-constructivistes).

Validité (vérité) et causalité

Le fait que vous ayez des mesures de bonne qualité et fiables ne garantit pas que votre recherche soit bien menée, tout autant que des phrases bien écrites ne suffisent pas à garantir qu’un roman soit bien écrit. Votre analyse doit être valable, dans la mesure où elle doit respecter une série d’exigences «logiques».

Voici le type de questions fondamentales que vous devez vous poser:

- Pouvez-vous réellement vous fier à vos conclusions?

- Avez-vous mal interprété des preuves statistiques de causalité?

La validité est un terme complexe: il existe, dans le milieu académique, de nombreux débats autour de la question de la validité des résultats.

Le rôle de la validité

La validité (comme la fiabilité, dont nous avons parlé précédemment) détermine la qualité formelle de votre recherche. Plus concrètement, la validité de votre travail (e.g. votre théorie ou votre modèle) est déterminée par la validité des composantes de son analyse.

Posez-vous quelques questions critiques, telles que:

- Pouvez-vous justifier vos interprétations?

- Ne seriez-vous pas victime de votre «préjugé de confirmation» à voir un résultat se confirmer? (Souvent, les chercheurs souhaitent voir leurs hypothèses se confirmer à tout prix)

- Pouvez-vous vraiment justifier la causalité dans une relation statistique (ou ne devriez-vous pas faire plus attention en affirmant que «X et Y sont liés»)?

Pour évaluer la qualité d’une recherche empirique, 6 éléments sont pris en compte, parmi lesquels la validité est l’élément le plus important. Le Tableau 15 présente les éléments de projets de recherche qui seront évalués. Nous indiquons également les critères d’évaluation qui sont largement utilisés.

|

Eléments de recherche |

Evaluations |

|

Théories |

Utilité / usage (compréhension, explication, prédiction) |

|

Cadres analytiques et modèles conceptuels |

Utilité / usage Construction (lien entre théorie et données, plus cohérence) |

|

Hypothèses et modèles |

Validité et construction logique (modèles) |

|

Méthodologie («approche») |

Utilité (pour la théorie et le déroulement de la recherche empirique) |

|

Méthodes |

Appropriées à la théorie, l’hypothèse, la méthodologie, etc. Utilisation correcte |

|

Données |

Bonne relation avec l’hypothèse et les modèles Fiabilité |

Tableau 15: Eléments évalués dans une recherche empirique

Ce tableau montre qu’un bon travail de recherche remplit tout d’abord un objectif mais qu’il doit également être mené selon des règles précises pour que les résultats soient considérés comme valables.

Voici le même message exprimé différemment, à l’aide d’un schéma (Figure 19):

- Le critère le plus important du point de vue de l’utilité et de l’usage est: «ce travail de recherche apporte-t-il une nouvelle pierre à notre connaissance sur le sujet? »

- Les critères formels les plus importants sont la 'validité' (étayer, avec des preuves solides, les liens de causalité découverts par l’étude) et la 'fiabilité' (montrer que le recueil de données, i.e. la mesure, est faite sérieusement)

- A mi-chemin entre les deux considérations précédentes: votre travail est-il cohérent et bien construit?

Quelques réflexions sur la causalité

Intéressons-nous de plus près à la causalité. La causalité dépend beaucoup de ce que l’on appelle la 'validité interne'. Qu’est-ce que la validité interne?

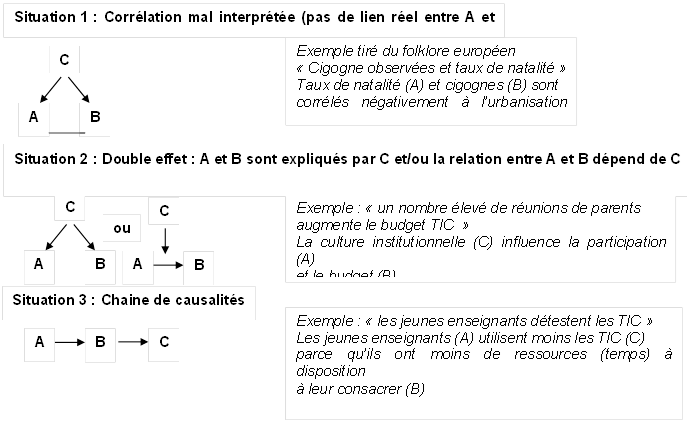

Pour comprendre ce concept, voici un premier principe clé: les corrélations entre des données prouvent peu de choses. En particulier:

- une corrélation entre deux variables (mesures) n’est pas une preuve de causalité

- une cooccurrence de deux événements ne prouve pas qu’ils sont liés

Le raisonnement pratique et théorique constitue le meilleur moyen d’éviter de telles erreurs!

Exemple: Prenons la supposition suivante: «L’utilisation des TIC dans l’enseignement augmente la satisfaction des apprenants». En s’appuyant sur une analyse des données superficielle, on pourrait tirer la conclusion suivante: «Nous avons introduit les TIC dans notre école et la satisfaction des apprenants est bien plus grande». Cependant, à bien y réfléchir, vous pourriez tester une autre hypothèse, selon laquelle la satisfaction ne résulte pas des médias (TIC). L’augmentation de la satisfaction peut simplement être due à d’autres variables de réorganisation de l’institution, qui à leur tour ont eu un impact sur de nombreuses variables intermédiaires telles que les relations entre enseignants et étudiants, l’investissement des enseignants, etc.

Par conséquent, retenez ces éléments:

- Si vous observez des corrélations de données, parlez de liens entre variables plutôt que de relation de causalité.

- Même si vous pouvez appuyer théoriquement votre conclusion par des preuves, vous avez le devoir de trouver une explication concurrente (i.e. la finalité de la recherche ne consiste pas à prouver qu’une théorie est vraie mais à prouver qu’elle est fausse selon la théorie de la falsification).

Quelques exemples de conclusions erronées

Voici quelques exemples de causalités cachées que l’on devrait détecter avant d’interpréter une corrélation apparente (Figure 20: Mauvaise interprétation de liens de causalité).

Bien entendu, il existe des méthodes quantitatives et qualitatives pour tester les variables qui influencent une corrélation... mais réfléchissez dans un premier temps, faites preuve de bon sens!

Conseils pratiques

Pour terminer cette brève introduction aux principes de la recherche empirique, voici quelques conseils:

- (1) A chaque étape de votre recherche, vous devez réfléchir et vous référer à la théorie

- De bons cadres analytiques (e.g. théories d’ingénierie pédagogique) donneront une structure à votre recherche et vous permettront de vous concentrer sur des éléments essentiels.

- (2) Faites une liste de tous les concepts qui apparaissent dans votre question de recherche et opérationnalisez-les

- Vous ne pouvez pas répondre à votre question de recherche sans avoir procédé à une opérationnalisation sérieuse. Identifiez les dimensions principales des concepts concernés et utilisez de bonnes grilles d’analyse!

- (3) Faites attention aux problèmes de validité

- Vous ne pouvez pas prouver une hypothèse (vous ne pouvez que la tester, la renforcer, la corroborer, etc.). Par conséquent, cherchez également des «contre-hypothèses»! De bonnes connaissances informelles d’un domaine vous aideront également. N’hésitez pas à demander l’avis d’un expert du domaine sur vos conclusions.

- Les approches de raisonnement purement inductives sont complexes et dangereuses... à moins que vous maîtrisiez une méthodologie adaptée (et coûteuse), comme par exemple la théorie ancrée.

- (4) Méfiez-vous de votre «tendance à pencher pour une confirmation»!

- Nous avons tous tendance, en tant qu’êtres humains, à chercher des éléments qui confirment notre raisonnement et à ignorer les éléments qui contredisent ce raisonnement. Il est pourtant de votre devoir, en tant que chercheur, de tester des hypothèses opposées (ou du moins de les prendre en considération)!

- (5) Essayez de généraliser (mais pas trop)

- Présentez votre travail à d’autres chercheurs pour leur montrer ce qu’ils pourraient en apprendre. Confrontez votre travail à celui d’autres chercheurs!

- (6) Utilisez une triangulation de méthodes, i.e. différentes façons de regarder un même objet de recherche

- Différents points de vue (et mesures) peuvent renforcer des résultats, et même les affiner. Imaginez par exemple que vous (a) meniez une étude quantitative sur les motivations des enseignants à utiliser les TIC à l’école ou que vous (b) administriez un sondage d’évaluation pour mesurer la satisfaction des utilisateurs d’un logiciel.

- Vous pourriez alors effectuer une analyse groupée de vos données et identifier des types d’utilisateurs principaux (e.g. 6 types d’enseignants et 4 types d’utilisateurs). Vous pourriez ensuite mener des entretiens qualitatifs avec 2 représentants de chaque type, «creuser» plus en détails leurs attitudes, leurs modèles subjectifs, leurs capacités, leurs comportements, etc., et confronter ces résultats avec vos résultats quantitatifs.

- (7) Création de théorie vs test de théorie

- Rappelons qu’il existe des types de recherches très différents, chacun possédant des avantages et des inconvénients. Les méthodes qualitatives sont plus adaptées pour créer de nouvelles théories (exploration / compréhension). Les méthodes quantitatives sont plus adaptées pour tester / affiner des théories (explication / prédiction). Bien sûr, il est possible d’utiliser plusieurs approches méthodologiques dans un même travail (méthodes mixtes).

Pour pratiquer:

- Pourquoi une corrélation entre deux variables n’est-elle pas nécessairement une «preuve» de relation?

- Citez les quatre étapes les plus importantes d’un projet de recherche empirique.

- Qu’est-ce qu’une hypothèse? Existe-t-il différents types d’hypothèses?

- Pourquoi est-il nécessaire d’avoir des données qui ont de la variance?

- Qu’est-ce que l’échantillonnage? Existe-t-il une différence, en ce qui concerne l’échantillonnage, entre la recherche quantitative et la recherche qualitative?

- Quelle est la différence entre la validité et la fiabilité?

{{#set:bloc pratiquer=true}}

Content of this article has been taken from EduTechWiki (en) or EduTechWiki (fr) at the date indicated in the history. DKS was the main founder and main contributor of EduTechWiki. If you cite this page you also must cite and credit EduTechWiki, according to the CC BY-NC-SA license. View the pageinfo-toolboxlink for this article.